[RLHF] PEBBLE: Feedback-Efficient Interactive Reinforcement Learning via Relabeling Experience and Unsupervised Pre-training

PEBBLE: Feedback-Efficient Interactive Reinforcement Learning via Relabeling Experience and Unsupervised Pre-training

Link : https://arxiv.org/pdf/2106.05091.pdf

Abstract

RL 에이전트에게 복잡한 objective를 전달하는 것은 종종 어렵고, 충분히 정보를 제공하면서도 충분히 쉽게 제공할 수 있는 보상 함수를 세심하게 디자인해야 한다. 그래서 human feedback을 통해 agent를 학습하는 방법이 있지만, 많은 양의 human feedback이 필요하므로 challenging하다. 해당 논문에서는 human-in-the-loop RL 에서, sample-efficient, feedback-efficient한 방법을 제안한다. 여기서 제안하는 방식의 특징은 off-policy learning과 feedback의 강점을 모두 가져가는 RL 알고리즘 이라는 것이다. 두개의 행동 클립 사이에서 teacher의 preference를 능동적으로 querying하여 reward model을 학습하고, 이를 agent training에 사용한다. off-policy trainining을 활성화하기 위해 reward model이 변경되면, 에이전트의 모든 과거 경험에 레이블을 다시 지정한다. 또한 unsupervised exploration을 통해 에이전트를 pretraining하면, 쿼리의 마일리지가 크게 증가한다는 것을 보여준다. 또한 이렇게 제안하는 방법이 기존의 human-in-the-loop RL에서 할 수 있었던 task보다 더 복잡한 task를 학습할 수 있음을 증명한다. 그리고 real-time human feedback을 활용해 reward exploitation을 효과적으로 방지하고, 기존 보상 함수로 할 수 없었던 어려우면서 새로운 행동을 학습할 수 있다.

Introduction

해당 논문에서 제안하는 방식을 사용하면, HiL learning을 통해 human effort의 양을 상당히 줄일 수 있다. 이를 위해 PEBBLE: unsupervised PrE-training and preference-Based learning via relaBeLing Experiences를 제안하고, PEBBLE은 supervisor가 제공하는 binary label(e.g. preference)로 보완되는 feedback-efficient RL 알고리즘이다. 그리고 특히 이는 unsupervised pretraining과 off-policy learning이 시너지를 낼 수 있다고 한다. generality를 위해 에이전트가 환경으로부터 보상을 받을 수 있다고 가정하지 않고, 에이전트가 경험을 다양하게 하고 일관된 행동을 생성하기 위해 intrinsic motivation만을 사용해 exploration을 하도록 한다. 다양한 경험을 수집하면 teacher는 의도하지 않은 방식으로 수집된 데이터에 대한 피드백에 비해 더 의미있는 피드백을 제공할 수 있다. 그런 다음, supervisor는 agent behavior clip pair 사이에 선호도를 표현하에 agent를 training한다. 에이전트는 이 정보를 reward model로 추출하고, RL을 사용해 추론된 보상 함수를 최적화한다.

Unsupervised learning을 활용하면 teacher의 초기 피드백의 효율성이 높은건 맞지만, RL에는 충분히 많은 수의 샘플이 필요하므로 supervising learning process는 그래도 사람의 노력이 아주 많이 필요하다. 따라서 데이터를 재사용해 에이전트와 사람의 효율성을 극대화할 수 있는 off-policy 알고리즘을 활성화하는 것이 특히 중요하다. 그러나 online learing으로 인한 non-stationary을 완화할 수 있다는 이유로 지금까지는 일반적으로 HiL RL에 on-policy가 사용되었다. reward model이 업데이트될 때마다 에이전트는 모든 과거 경험에 레이블을 다시 지정하기만 하면, 에이전트가 수집한 모든 경험을 활용하고 재사용할 수 있다. 수집된 모든 agent의 경험을 재사용해 sample efficiency와 feedback efficiency를 크게 개선할 수 있다.

해당 논문에서 주장하는 main contribution은 아래와 같다.

- 처음으로 unsupervised pre-training과 off-policy learning은 HiL RL의 sample/feedback-efficiency를 상당히 향상시킬 수 있음을 보인다.

- PEBBLE은 이전 preference-based RL에 비해 월등한 성능을 보인다.

- PEBBLE은 일반적인 보상 함수를 설계하기 어려운 행동을 학습할 수 있음을 입증했다.

Preliminaries

Reinforcement learning

이 논문에서는 agent가 discrete time으로 enviroment와 상호작용하는 standard RL framework를 고려한다. 그리고 discounted sum of rewards 를 maximizing하는 policy pi를 learning하는 것이 RL의 목표이다.

Soft Actor-Critic

SAC는 off-policy actor-critic method로,exploration을 할 수 있게 하면서 policy entropy오 reward의 weighted objective를 maximizing함으로써 noise에 강건한 maximum entropy RL framework이다. SAC는 soft policy evaluation과 soft policy imporvement를 반복하며 파라미터를 업데이트하고, soft policy evaluation step에서는 아래 ovjective를 minimizing하는 soft Q function을 학습한다.

tau_t는 transition, B는 replay buffer, \bar{\theta}는 delayed parameter이며 alpha는 temperature 파라미터이다.

Soft policy improvement step에서는 policy pi_\phi가 아래와 같은 objective를 minimizing하는 방향으로 학습된다.

SAC는 on-policy 알고리즘들에 비해 과거 experience를 다시 사용함으로 sample-efficienct하다. 그러나 같은 이유로 SAC도 non-stationary reward function에는 로버스트하지 않다.

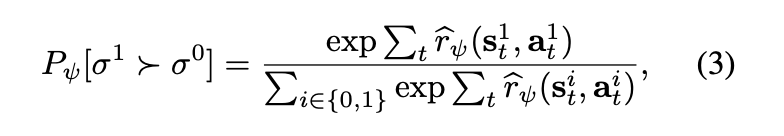

Reward learning from preferences

human feedback데이터로부터 prefernece에 대한 reward function \hat{r_\psi}를 배우는 것에 대해 얘기한다. observation의 시퀀스 segment \sigma와 action이 주어지면, preference y는 두 segment 중 어떤 것을 더 선호하는지에 대한 라벨이다. 아래 Bradley-Terry model 식으로 preference predictor를 학습하게 된다.

sigma_1 > sigma_0은 segment 1을 더 선호한다는 것을 나타내고 y는 (1,0)이 된다. 직관적으로, 이는 선호도의 확률이 exponentially sum over the segment of reward function에 의존한다고 가정하는 것으로 설명된다. 보상 함수는 binary classifier가 아니고, teacher가 제공한 레이블 y를 사용하여 이진 분류를 하는 것과 같다. 더 자세하게, 보상 함수는 psi parameterizing된 neural net으로 모델링되며, 아래 식을 minimizing하는 방향으로업데이트 된다.

PEBBLE

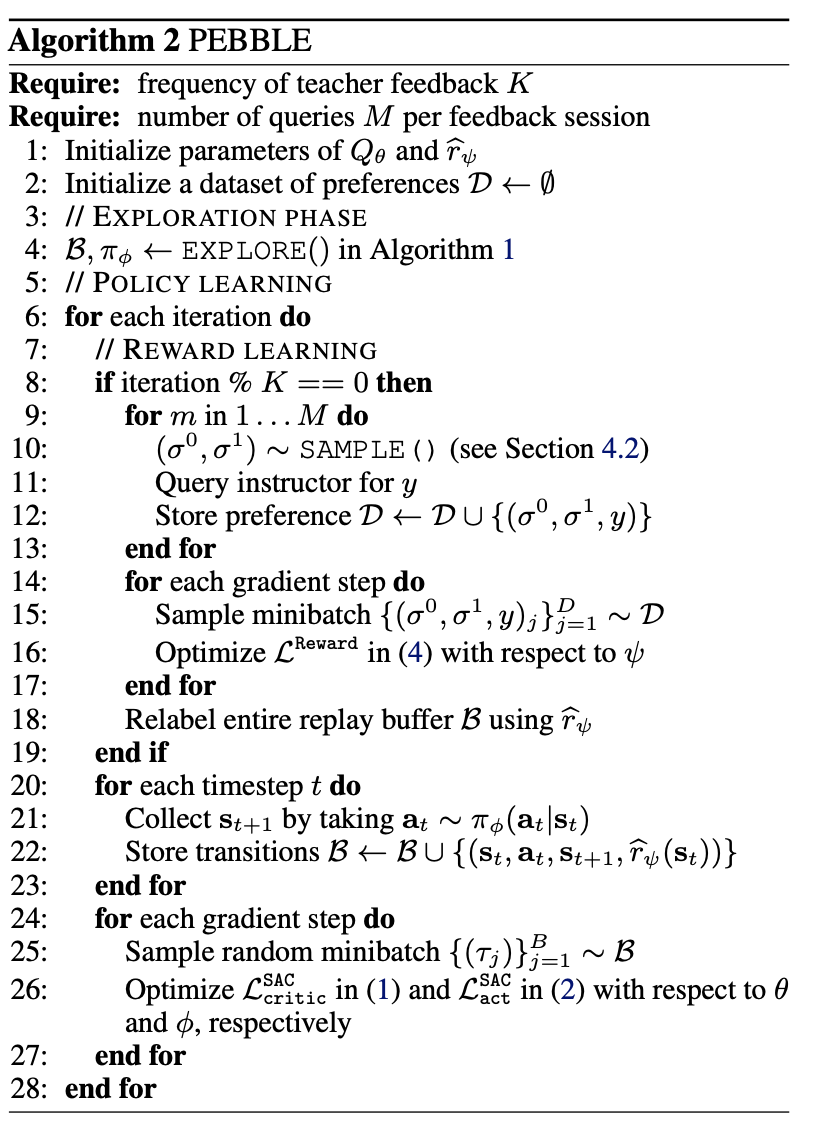

policy, Q-function, reward function을 학습하기 위한 3개의 스텝이 있고 1,2스텝이 반복되며 각 파라미터를 업데이트한다. 먼저 Step0은 unsupervised pre-training 단계로, 다양한 experience를 모으기 위해 exploration을 intrinsic motivation을 사용해 진행하고 policy pi_\phi를 사전학습한다. 그리고 Step1은 reward learning 단계로, teacher로 부터 받은 feedback으로 desired behavior를 이끌 수 있는 reward function을 학습한다. Step 2는 agent learning 단계로, non-stationary reward function \hat{r_\psi}의 효과를 완화하기 위해 relabeling을 통한 off-policy RL 알고리즘을 통해 policy pi_phi와 q-function Q_\theta를 업데이트한다.

Accelerating Learning via Unsupervised Pre-training

훈련 초기에는 agent가 random policy를 실행하기 때문에 state coverage나 coherent behavior을 제공하지 않는다 따라서 에이전트의 쿼리는 매우 제한적이고 human teacher가 판단하기 어려울 가능성이 높다. 따라서 이 방법이 inital process를 보여주기 위해서는 많은 샘플(쿼리)가 필요하다. 최근 연구세너는 데모를 제공하는 방식으로 이를 해결했지만, 데모는 구하기 어려워 이상적이지 않다. 대신 저자들의 통찰력은 훈련 시작시 unsupervised learning을 활용해 intrinsic motivation을 통해서만 다양한 샘플을 수집해 유익한 쿼리를 생성하는 것이다.

특히 state entropy를 intrinsic reward로 사용해 agent가 더 넓은 state를 방문할 수 있도록 한다. state entropy H(s) :

에이전트가 sum of expected intrinsic reward를 maximize하는 쪽으로 업데이트함으로써, 효과적으로 exploration을 할 수 있고 다양한 behavior를 생성할 수 있게 된다. 그러나 intrinsic reward는 대부분의 setting에서 계산하기 intractable하다. 이 이슈를 해결하기 위해 particle-based entropy estimator의 간단한 버전을 사용했다.

\hat{H}는 particle-based entropy estimator이고 s_i의 s_i^k는 k번째 이웃이다. 이는 state와 가까운 이웃 사이의 거리를 증가시키는 것을 의미한다. 이를 활용해 저자들은 intrinsic reward를 아래와 같이 정의했다.

그리고 exploration을 위한 unsupervised pre-training 수도 코드는 아래와 같다.

Selecting informative Queries

앞에서 언급했듯, teacher가 샘플링된 세그먼트 중 하나를 다른 세그먼트보다 선호할 확률을 세그먼트에 대한 reward의 지수 합에 비례하는 것으로 모델링해서 보상 함수를 학습한다. 이상적으로는 결과 보상 모델에 대한 최적화를 통해 에이전트가 Expected value of Information(EVOI)를 maximizing하도록 preference를 요청해야한다. 하지만 EVOI를 계산하는 것 또한 updated policy에 의한 모든 가능한 trajectory들의 expectation을 계산해야 하기 때문에 intractable 하다. 이를 해결하기 위해 보상 모델을 변경할 가능성이 있는 쿼리를 샘플링 하기 위한 몇 approximation 방법들이 연구되었다. 이전 연구에서 사용한 샘플링 방식은 uniform sampling과, 분산이 큰 세그먼트 쌍을 선택하는 ensemble-based sampling, entropy-based sampling 등이 있다. entropy-based sampling은 decision boundary에 가장 가까운 세그먼트 쌍을 모호하지 않게 하는 방법이다. 즉 대량의 세그먼트 쌍을 샘플링해 H(P_\psi)를 최대화하는 쌍을 선택하는 것이다. 그리고 실험에서 여러 샘플링 기법을 비교하였다.

Using Off-policy RL with Non-stationary Reward

일단 reward function \hat{r_psi}를 학습하면, policy pi_\phi와 Q-function Q_\theta를 RL알고리즘을 사용해 업데이트 할 수 있다. 주의할 점은 보상 함수는 training 중에 업데이트하기 때문에 non-stationary하다. 이를 해결하기 위한 이전 방법들은 sample-efficiency가 낮기 때문에 전체 HiL method에 feedback하기 좋지 않다.

해당 논문에서는 리플레이 버퍼에 저장된 과거 experience를 재사용해 샘플을 효율적으로 학습할 수 있는 Off-policy RL 알고리즘을 사용한다. 그러나 replay buffer의 past experience는 이전에 학습한 보상으로 레이블이 지정되어 있어 off-policy rl 알고리즘의 학습 프로세스가 불안정 할 수 있다. 이 문제를 해결하기 위해 모든 과거 experience data에 레이블을 다시 한다. 이 간단한 기법을 통해 학습 프로레스가 크게 안정화되고 성능이 향상되는 것을 확인했다고 한다.

PEBBLE의 전체 알고리즘은 아래와 같다.

Conclusion

PEBBLE은 피드백과 샘플 효율이 높은 HiL RL알고리즘이다. unsupervised learning과 off-policy 알고리즘을 사용하여 비용이 큰 human feedback을 적게 사용해 이전 연구들보다 더 복잡한 task를 수행할 수 있음을 보여주었다. 또 PEBBLE은 새로운 행동을 학습하면서도 reward exploitation을 피할 수 있고, 엔지니어링된 보상 함수로 훈련된 에이전트에 비해 더 desired behavior를 유도할 수 있음을 보여준다. Preference-based learning을 더 쉽게 실행할 수 있게 함으로써, PEBBLE은 전문가가 보상 함수를 신중하게 제작할 수 있는 환경을 넘어 일반인도 로봇의 발전을 활용할 수 있도록 할 수 있게 하고 싶다고 저자들은 얘기한다.

'자연어 NLP' 카테고리의 다른 글

당신이 좋아할만한 콘텐츠

-

[NLP] Information-Transport-based Policy for Simultaneous Translation 2023.05.28

-

[NLP] Translation-based Supervision for Policy Generation in Simultaneous Neural Machine Translation 2023.05.12

-

[RLHF] Preference Transformer: Modeling Human Preferences Using Transformers For RL 2023.04.28

-

[NLP] Hidden Markov Transformer for Simultaneous Machine Translation 2023.04.20

소중한 공감 감사합니다