[NLP] DeepConf: Deep Think With Confidence

DEEP THINK WITH CONFIDENCE

https://arxiv.org/pdf/2508.15260

Introduction

최근 LLM의 reasoning 과제를 풀 때, test-time scaling 기법을 이용해 모델의 사고 과정을 확장하는 방식이 많이 사용된다.

그 중 병렬적 사고 Parallel thinking은 모델이 한 번의 입력에 대해 여러 개의 추론 경로(reasoning path)를 동시에 혹은 반복적으로 만들어내는 기법이 있다. sampling temperature나 random seed등을 바꿔서 서로 다른 사고 과정을 생성해낸다. 사람이 사고하는 것 처럼 여러 가설을 동시에 떠올리고 가장 많이 나온 혹은 가장 설득력 있는 답변을 선택하는 것이다.

Parallel thinking 전략 중 기본적이고 대표적인 방법은 Self-Consistency with majority voting이다.

한 문제에 대해 temperature를 변경해 수십, 수백번의 CoT reasoning trace를 샘플링하고 여러 추론 경로를 다수결로 통합하는 방식이다. 이 방법은 단일 경로로 추론할 때보다 훨씬 더 좋은 정답률을 보이지만, 한계점과 문제도 존재한다.

1. Dinimishing returns(수익 체감) 현상

추론 경로(Reasoning trace)수가 많아진다고 무조건 성능이 좋아지는 것이 아니라, 오히려 성능 향상이 둔화되거나 악화되는 현상을 의미한다. 이유는 모든 Reasoning trace를 동일하게 취급하기 때문에 낮은 품질의 추론 경로가 다수이면 오히려 전체 성능에 저하가 발생한다.

2. Overhead

추론 경로를 많이 만들면 만들수록 생성해야 하는 토큰의 수가 증가하고 결국 추론 실행 비용이 커진다. 예시로 AIME 2025 수학 문제에서 Qwen3-8B를 사용해 단일 추론 패스로 테스트를 하면 pass@1 68%정확도를 달성한다. 여기서 성능을 82%로 올리는데 추가로 511개 이상의 추론 경로를 생성했고 1억 개 이상의 토큰을 추가로 생성해야 했다.

3. Global Confidence 한계

각 추론의 품질을 측정하기 위해 중간 스텝은 무시하고 전체 reasoning trace 단위로 품질을 측정하는 Global Confidence 를 사용하는 경우가 많다. 이렇게 측정한 값으로 낮은 품질의 추론을 걸러낸다. 하지만 전체 CoT단계나 전체 토큰의 평균 품질이기 때문에 특정 CoT 스텝에 문제가 있더라도 묻히게 되는 문제점이 있다. 전체적으론 Confidence가 높지만 중간에 틀린 사고를 걸러낼 수 없다는 것이다. 또한 모든 추론 경로를 완전히 생성한 이후에야 전역 Confidence를 계산할 수 있기 때문에 저품질 추론을 조기에 중단(early stopping)을 할 수 없다.

해당 논문은 이러한 한계를 극복하기 위해 제안되었다. parallel thinking을 할 때 reasoning trace에 대한 품질을 전역이 아닌 Token-level로 측정이 가능하도록 하였다. 이로 인해 early stopping이 가능하여 computational overhead를 줄이고 정밀한 품질 측정이 가능하다는 것이 큰 장점이다.

Confidence as an Indicator of Reasoning quailty

품질 지표로서 Confidence에 대해 살펴보자. 모델 내부에서 감지할 수 있는 Confidence 신호가 어떤 추론 경로가 품질이 높을 가능성이 있는지를 판별하는 데 유용하다는 것을 보여주는 부분이다. 먼저 Confidence metrics를 정의하고 그것들이 실제로 추론 경로의 정답 여부와 얼마나 상관관계가 있는지를 보여준다.

먼저 토큰 엔트로피(Token Entropy $H_i$)는 모델이 $i$번째 토큰을 생성할 때 갖는 확률분포 $P_i$에 대해 (1)수식과 같이 정의한다. 낮은 토큰 엔트로피는 확률이 한쪽으로 치우쳐져 있고 이 경우 토큰 생성에 대해 충분한 정보를 갖는다는 것을 의미한다.

토큰 신뢰도(Token Confidence, $C_i$)는 $i$번째 토큰 생성시 상위 k개의 토큰의 로그확률을 평균내고 마이너스를 붙여 수식(2)와 같이 정의한다. 여기서 k는 하이퍼파라미터로 top-k의 토큰 갯수를 의미하며 모델이 이 위치에서 상위 몇 개 후보에 얼마나 확신을 가지고 있었는지 보는 수치이다.

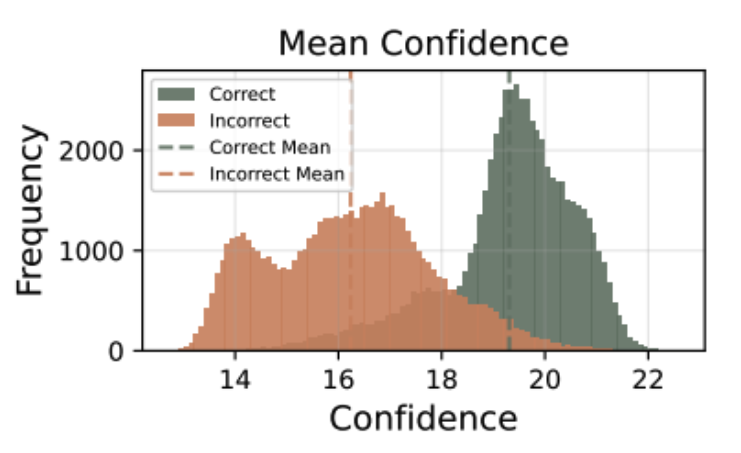

그리고 평균 경로 신뢰도(Average Trace Confidence, $C_{avg}$는 하나의 추론 경로(trace) 전체 토큰 $i=1...N$에 대해 $C_i$를 평균낸 값으로 수식(3)과 같이 나타낼 수 있다. 이는 전체 경로에 대한 평균 Confidence 즉 Global Confidence 를 의미한다. 위의 Mean Confidence 그림과 같이 이 값이 정답을 도출한 경우와 그렇지 않은 경우 유의미한 차이를 보인다고 하였다. 더 높은 평균 confidence를 가진 경로들이 대체로 정답일 가능성이 높으니 이 값은 trace 품질 측정의 척도로 사용하기 적합하다는 것이다.

결론적으로 이런 Token distribution은 모델의 외부 추가 학습이나 레이블링 없이도 효과적으로 좋은 추론을 구분할 수 있는 Model-intrinsic signal을 제공한다. 단일 토큰의 confidence만으론 전체 추론의 품질을 평가하기 얼벼기 때문에 대부분 confidence 관련 연구들은 토큰 수준의 Confidence를 전체 추론 경로 단위로 집계하여 사용한다. 전체 추론의 평균 confidence(self-certainty)는 전체 생성된 토큰 수 N에 대한 평균 신뢰도 값이다. 즉 추론 과정 전체 평균 confidence를 통해 추론 경로 전체 품질을 수치화 한 것이다.

하지만 이 경우 위에서 언급한 것과 같이 다음과 같은 문제가 있다.

1. Global aggregation obscures intermediate reasoning fails

추론 경로의 각 Step은 각 step마다 Confidence가 크게 출렁인다. 일부 CoT step이 결정적인 오류(logical breakdown)을 냈더라도 평균 값은 그 값을 묻는다.

2. Preventing early termination of low-quality generations

전체 추론 경로를 끝까지 생성해야만 confidence를 구할 수 있기 때문에, 낮은 품질의 추론을 early stop할 수 없어 computational inefficiency를 유발한다

DeepConf는 평균 대신 local로 Confidence를 구하는 방법을 제안한다. 추론 경로를 윈도우로 나눠 각 윈도우의 confidence variation를 추적하여 early stop도 가능하게 하자는 심플한 아이디어다. 기존의 전역 신뢰도가 세밀한 단계별 추론 품질을 구분하지 못하는 한계를, 추론 과정의 로컬(intermediate) 품질 신호를 포착하자는 것이다. 이들은 추론 경로의 '어느 구간에서 생각이 흔들렸는가'를 포착하는 데 초점을 맞춘다.

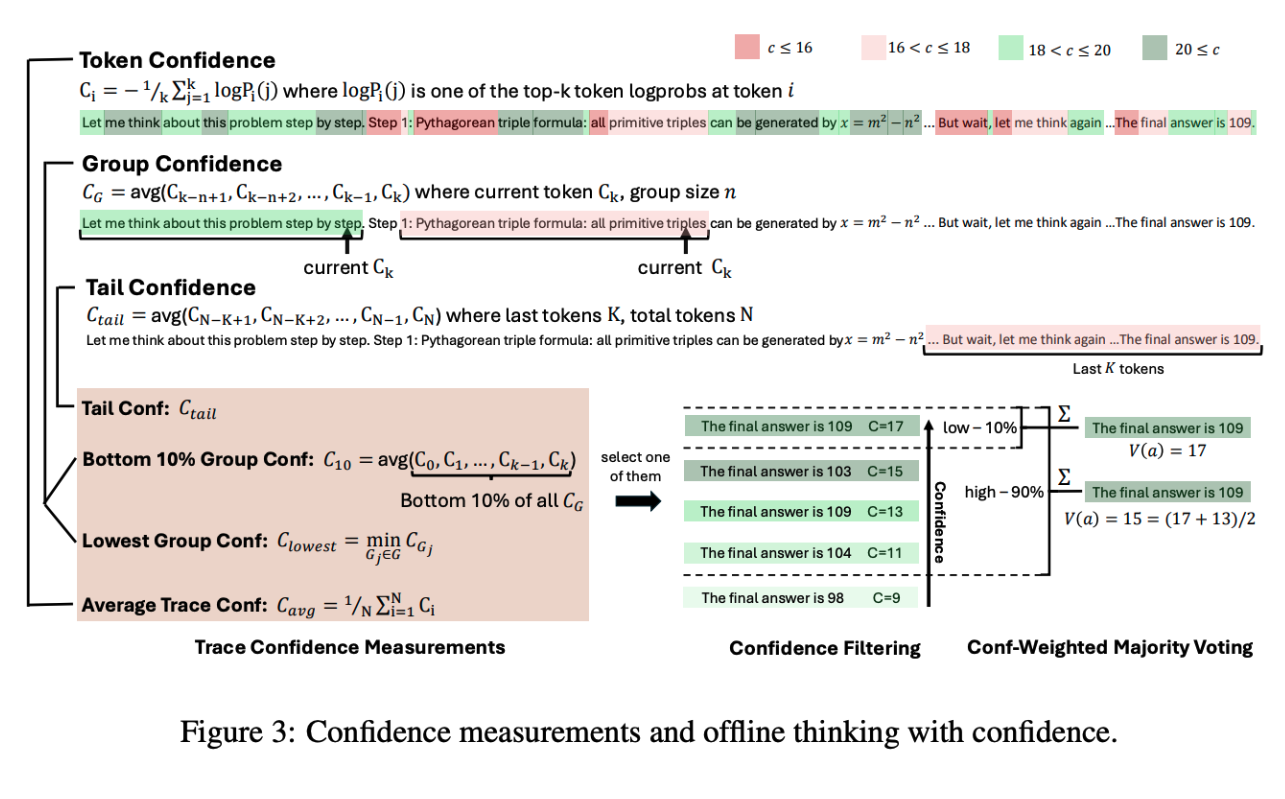

Confidence Measurements

DeepConf는 위 한계를 극복하기 위한 몇 가지 더 정교한 지표를 제시한다. 이들은 로컬 신뢰도나 최하위 신뢰도 구간 등을 분석할 수 있게 설계돼 있다.

먼저 그룹 신뢰도(Group Confidence, $C_{G_i}$는 추론 경로를 슬라이딩 윈도우 방식으로 나눈 '그룹' 단위로 토큰 신뢰도 $C_t$를 평균낸다. 여기서 윈도우는 '토큰 길이' 단위이다. 그리고 각 구간은 오버랩된다. 이걸 통해 이 구간(그룹)에서 모델이 Confidence가 얼마나 높았는지 세밀하게 볼 수 있다. 이렇게 하면 reasoning 중간 단계의 확신 정도를 보다 부드럽고 지역적으로(local) 추적할 수 있다. 실험적으로, reasoning 도중에 특정 구간에서 confidence가 급격히 떨어지는 경우(예: “wait”, “however”, “think again” 등의 표현이 반복되는 시점), 그 후의 논리적 흐름이 무너지고 오답으로 이어지는 경향이 뚜렷하게 나타났다. 즉, 중간에 confidence가 붕괴된 구간이 최종 정답에 큰 영향을 미친다는 것이다.

Bottom 10% 그룹 신뢰도($C_{bottom-10}(t)$)는 한 경로 내부에서 신뢰도가 가장 낮은 상위 10%를 골라 평균을 낸다. 즉 이 경로에서 가장 약했던 10% 구간의 평균 confidence를 본다는 직관적 방법이다. 전체 구간 중에서도 특히 가장 불확실한(low-confidence) 부분이 추론 실패의 원인이 되는 경우가 많다. 이를 반영하기 위해, 가장 confidence가 낮은 10% 구간의 평균값을 측정한다. 경험적으로, 이 “하위 10%”는 다양한 모델과 데이터셋에서 가장 문제적인 reasoning 단계를 포착하는 데 충분하다고 밝혀졌다. 이 지표는 “평균적으로 자신 있는 구간이 많아도, 중간에 10% 구간이 무너졌다면 전체 추론의 신뢰도는 낮다”는 사실을 수치화한다.

최저 그룹 신뢰도(Lowest Group Confidence, $C_{least}$)는 경로에서 신뢰가 가장 낮은 하나의 그룹의 값만 보는 방식이다. “이 추론에서 가장 자신 없었던 순간의 정도”가 전체 품질의 핵심 판단 기준이 된다. 이 지표는 온라인 추론(online thinking) 상황에서 특히 유용하다. 모델이 reasoning 도중에 일정 임계치(threshold) 이하로 confidence가 떨어지는 구간을 만나면, “이건 틀릴 확률이 높다”고 판단해 조기 종료(early stopping) 를 할 수 있기 때문이다.

그리고 꼬리 신뢰도(Tail Confidence, $C_{tail}$)는 경로의 마지막 일정 토큰 수(e.g. 마지막 2048 토큰)만 골라 평균 신뢰도를 보는 방식이다. 추론의 마지막 부분(tail) 은 정답의 정확도에 큰 영향을 미친다. 특히 수학적 추론에서 결론부는 해답을 확정하는 단계이므로, 초반에는 논리적이었더라도 끝에서 흐트러지면 전체 답이 틀릴 수 있다. 이를 포착하기 위해, reasoning trace의 마지막 일정 길이(예: 2048 토큰) 구간만의 평균 confidence를 계산한다: 즉, reasoning의 “마무리 구간에서 모델이 얼마나 확신에 차 있었는가”를 평가하는 지표다.

Offline Thinking with Confidence

그리고 논문에서는 Offline thinking과 Online thinking을 나눠 제안된 Confidence를 적용하는 방법을 보여준다. 먼저 오프라인 사고란 이미 하나의 문제에 대해 여러 추론 경로가 생성된 상태에서 이들을 어떻게 조합하고 판단하여 최종 답을 결정할지를 다루는 과정이다.

먼저 Majority voting은 가장 기본적인 접근법으로 각 reasoning trace가 낸 최종 답안을 동등하게 한 표씩 행사하도록 하는 방식이다. T는 모든 reasoning trace 집합을 의미한다. $V(a)$는 후보 답변 a에 대한 투표수이다. 그리고 Indentity function은 참이면 1 거짓이면 0을 반환하는 indicator 함수다. 최종적으로 가장 많은 표를 얻은 답이 선택된다. $\hat{a} = \arg\max_{a}V(a)$ 이 방식은 단순하고 강력하지만, 모든 추론의 품질을 동일하게 취급하기 때문에 confidence가 낮은, 즉 신뢰할 수 없는 reasoning도 같은 영향력을 갖는다는 단점이 있다.

그리고 Confidence-Weighted Majority Voting는 이 문제를 해결하기 위해, 각 reasoning trace가 가진 confidence 값$C_t$ 을 가중치로 사용한다. 즉, 신뢰도가 높은 trace의 투표가 더 큰 영향력을 갖도록 설계한다. 여기서 $C_t$는 해당 reasoning trace t의 신뢰도 점수로, 앞서 제시된 여러 측정법(예: 평균 신뢰도, 그룹 신뢰도, 꼬리 신뢰도 등) 중 하나를 선택해 사용할 수 있다. 이 방식은 “모든 추론을 똑같이 취급”하지 않고, ‘자신 있는 reasoning’에 더 많은 표를 주는 투표라 할 수 있다. 그 결과, confidence가 낮은, 즉 불확실하거나 비논리적인 reasoning이 최종 결정에 미치는 영향을 크게 줄일 수 있다.

Confidence Filtering

Confidence-Weighted Majority Voting에 더해, confidence가 낮은 reasoning trace 자체를 사전에 제거하는 단계도 추가한다. 이를 confidence filtering이라 부르며, confidence 점수를 기준으로 상위 $\eta$%의 reasoning trace만 남기고 나머지는 버린다.

- $\eta$ = 10% → confidence가 가장 높은 상위 10%만 사용

- 소수의 매우 신뢰도 높은 추론에 집중

- 효율적이지만, 모델이 특정 방향으로 편향되어 있을 경우 잘못된 답으로 수렴할 위험이 있음

- $\eta$ = 90% → 상위 90%만 필터링 없이 유지

- 더 많은 reasoning을 반영해 다양성과 안정성을 확보

- “너무 자신 있는 소수의 추론에 휘둘리지 않게” 하는 완충 효과

이 필터링 비율은 모델의 특성과 confidence 분포 형태에 따라 조정할 수 있다. Confidence 분포가 균일할 경우, 90% 옵션이 균형 잡힌 선택으로 작동한다.

이 오프라인 사고 과정 절차를 정리해보면,

1. 먼저 동일한 문제에 대해 N개의 추론 경로를 생성한다 그리고 각 경로 t에 대한 답이 있고 해당 경로의 신뢰도 점수 $C_t$를 계산한다. (그림 상단)

2. 신뢰도 지표는 token confidence, group confidence, bottom 10% confidence, tail confidence 중 하나 혹은 조합을 사용할 수 있다. (그림 중단)

3. Confidence filtering을 적용한다. 이때 생성된 N개의 경로 중 상위 $\eta$%만 선택하는 방식이다. (그림 중단 우측)

4. Confidence-Weighted Majority voting을 적용해 필터링 된 경로 집합에서 각 답변 후보a에 대해 가중치를 곱해 투표를 한다. 최종 선택은 이 가중투표 결과 $V(a)$가 가장 큰 답변을 고르는 것이다. (그림 하단)

기존 다수결 방식은 모든 경로를 동일하게 취급하기 때문에 신뢰도가 낮은 경로들도 투표에 동등하게 기여하게 된다. 이 때문에 저품질 경로가 투표 결과에 악영향을 줄 수 있다. 여기서 제안한 방식은 신뢰도 기반 필터링과 가중 투표를 이용해좋은 경로의 영향력은 키우고 나쁜 경로의 영향력은 줄이는 효과가 있다. 이렇게 함으로써 동일한 생성 budget 내에서 더 높은 정확도를 얻거나 같은 정확도에서 생성량(token) 비용을 줄일 수 있다는 것이 장점이다.

논문에서도 이 방법의 주의사항에 대해 언급하는데, 신뢰도 점수 $C_t$가 항상 정답 경로를 완벽하게 구분해 주지는 않는 다는 점이다. 신뢰도가 높은데 잘못된 답이 나올 수 있고 신뢰도가 낮은데도 맞는 답일 수 있다.

그리고 필터링해 경로 수를 줄이면 diversity가 떨어질 수 있다. 너무 극단적으로 필터링하면 모델이 잘못된 자만감을 갖고 틀린 답을 많이 내는 경로만 남는 위험이 있다.

오프라인 방식은 생성이 모두 끝난 뒤 평가, 투표를 하므로 early stop이 불가능하다. 그래서 Online 방식도 제안하여 이 문제를 해결한다.

Online Thinking with Confidence

온라인 사고과정은 추론이 진행되는 도중 실시간으로 conf를 평가하여 품질 낮은 추론 경로를 조기에 earlystop 하는 방법이다. 계산 자원이 한정된 환경이나 빠른 응답이 필요한 상황에서 유용하다. 핵심 아이디어는 추론을 이어가다 지금 생각이 이상하다는 신호(conf 하락)이 나타나면 그 즉시 멈춘다.

온라인 환경에서는 Lowest Group conf를 기반으로 한다. 추론 중 특정 구간(윈도우)의 평균 conf가 threshold 이하로 떨어지면 그 즉시 중단하는 것이다.

조기 종료가 가능하도록 하기 위해 Offline warmup과 Adaptive sampling을 적용한다.

먼저 Offline warmup은 온라인 추론 전 짧은 웜업단계를 통해 confidence 임계값 s를 결정하기 위한 것이다. prompt 입력 후 N(e.g.16) 추론 경로를 완전히 생성한 후 각 경로의 conf를 계산해 집합 T_warmup을 만든다. 그 중 상위 $\eta$ % conf 값으로 임계값을 설정한다. $\eta=10$은 DeepConf-low라고 명명하였고 상위10%만 유지하는 매우 공격적인 필터링이다. 필터링의 conf값이 조금만 낮아도 즉시 중단한다. 효율성을 극대화 하는 대신 위험성이 크다. $\eta=90$은 DeepConf-high이고 더 보수적인 필터링으로 conf값이 조금만 불확실해도 계속 생성한다. 안전하지만 그만큼 절약 효과가 적다.

Adaptive sampling은 문제 난이도에 따라 생성할 추론 경로를 동적으로 조절하는 것이다. 문제의 난이도는 추론 경로의 합의 정도로 측정됨. 즉 여러 경로가 내논 답이 얼마나 일치하는 지를 본다. $\hat{a}$는 다수결로 얻어진 잠정적 정답, $V(a)$는 답변 a를 지지하는 총 conf 가중치, 미리 설정된 임계값 $\tau$(e.g. 0.95) 기준으로 임계값보다 베타가 작으면 아직 의견이 갈린다고 판단해 추론을 더 생성하고 크거나 같으면 충분히 일치하므로 멈춘다. 이 과정은 문제 난이도에 따라 추론 양을 자동으로 조절하게 한다.

이 방식은 오프라인 필터링의 실시간 버전이다. 워밍업을 통해 임계값 s가 충분히 정확하면 생성 도중 중단한다. 중단된 trace는 오프라인 방식에서 어차피 conf 필터링으로 제외될 것들이라는 것이다. 오프라인에서 나중에 걸러낼 추론을 온라인에서 애초에 만들지 않는 것이 핵심 아이디어다. 이걸로 계산 비용을 크게 줄일 수 있다. 실험적으로 워밍업크기 N이 커질 수록 임계값 s의 추정이 더 안정적인 것을 확인하였다.

온라인 사고과정의 절차를 단계별로 보면

1. 병렬 추론을 시작한다. 모델은 한 번에 여러 추론 경로를 생성한다. 각 경로는 token-by-token으로 확장되며, 매 토큰마다 확률분포(softmax output)를 계산한다.

2. 실시간 신뢰도를 계산한다. 각 단계에서 모델의 내부 확률분포를 이용해 Group Confidence 같은 신호를 계산한다. 구체적으로는 일정 길이의 토큰 윈도우(window)를 잡고, 해당 구간의 평균 토큰 신뢰도 $C_{G_i}$ 또는 최저 그룹 신뢰도 $C_{least}$ 등을 측정한다.

3. 조기 종료를 한다. 만약 현재까지 신뢰도 지표가 사전 정의된 s이하로 떨어지면 생성을 중단한다.

4. 결과 집계, 모든 경로를 다 생성하지 않고 살아남은 경로만 모아 오프라인 단계처럼 다수결 혹은 weighted voting을 수행해 최종 답을 고른다.

실험 결과

오프라인 환경에서 기존 Self-Consistency보다 정확도를 개선한 결과이다.

지표

| Pass @ 1 | reasoning trace 1개만 생성했을 때의 기본 정확도 (기준선) |

| Cons @ 512 | 512개의 trace를 생성하여 다수결로 결정 (표준 Self-Consistency) |

| Mean @ 512 | 모든 trace의 평균 confidence를 가중치로 한 투표 (global confidence) |

| Bottom-10 Conf @ 512 | 각 trace의 하위 10% confidence 구간의 평균값으로 가중치 부여 |

| Tail Conf @ 512 | reasoning 끝부분(마지막 2048 토큰)의 confidence로 가중치 부여 |

| Retention Ratio 90 % / 10 % | confidence filtering으로 상위 $\eta$% ($\eta$=90 또는 10)만 남긴 비율 |

DeepConf가 제안한 “bottom 10% confidence” 및 “tail confidence” 측정이 기존의 평균 confidence (weighted mean)나 단순 다수결보다 얼마나 낫고, 필터링 비율 ($\eta$=10 vs 90) 이 결과에 어떤 영향을 주는지를 비교한다.

deepconf는 단순 다수결보다 더 높거나 동일한 성능, 10% 필터링이 가장 큰 성능 향상. 소수 고품질 추론 경로가 정답 결정에 충분하다는 것을 보여주었다.

- Mean confidence (평균값) 은 기존 Self-Consistency와 유사하거나 약간 개선되었다.

- Bottom 10 % confidence 와 Tail confidence “불안정하거나 후반부에 흔들리는 reasoning”을 효과적으로 잡아내더 높은 정확도를 내었다

일부 모델(예: GPT-OSS-120B)에서는 과도한 필터링이 오히려 정확도 저하를 보이기도 하였는데, 저자들은 모델이 “틀린 결론을 확신하는 경우(over-confident mistakes)” 때문이라고 한다.

이 결과를 통해 평균보다는 부분적(confidence 하락 구간 또는 결론부) 신호가 더 신뢰할 만한 품질 판별 지표라는 것을 보여주었다.

그리고 온라인 모드 실험 결과이다. deepconf가 실제 추론 중 conf 이용해 조기 중단할 경우 정확도와 토큰 효율이 어떻게 변하는 지 정량적으로 보여주었다.

추론 경로 512개 생성, 기존 다수결(전체 생성), high, low 비교하였다.

- DeepConf는 대부분의 모델·데이터셋에서 기존 다수결과 동등 또는 더 높은 정확도 를 보이면서,

- 평균 50 ~ 80 %의 토큰 절감을 달성

- 특히 AIME·BRUMO 같은 고난도 수학 문제에서 효과가 뚜렷

- GPT-OSS-120B 처럼 대형 모델에서도 성능 손실 없이 막대한 효율 향상 확인.

deepseek 토큰을 70퍼 줄이면서 정확도는 오히려 향상되었으며 qwen 대부분 정확도 동등 또는 소폭 상승하였다. 전체적으로 토큰 비용 절감 40-67퍼 정도이다.

결론

이 논문은 Thinking의 품질을 스스로 판단하게 했다는 점에 의의가 있다. Self-Consistency는 여러 번 생각하고 다수결로 결정하는 접근이라면 DeepConf는 추론이 얼마나 믿을만한가, 모델 내부 확률 신호로 직접 평가했다. 불필요한 추론 경로를 거르고 정확도와 효율을 동시에 달성하였다.

또한 Test-time Compression의 대표적 사례로 볼 수 있는데, 더 적은 연산으로 정확한 답을 내는 추론 최적화로 볼 수 있다. 추가 학습 없이 단순한 기법으로 작동한 다는 점도 장점이다. Confidence를 계산하고 Threshold 기반 필터링을 하는 경량 알고리즘이다. 구현도 간단하다.

다만 신뢰도 ≠ 정답률 완벽한 지표 아니라는 점과, 임계값 설정에 주의가 필요하다는 것을 주의해야 할 것 같다.

'자연어 NLP' 카테고리의 다른 글

당신이 좋아할만한 콘텐츠

-

[AI Safety] Subliminal Learning: Language models transmit behavioral traits via hidden signals in data 2025.09.29

-

[Agent] Plan-and-Act: Improving Planning of Agents for Long-Horizon Tasks 2025.07.20

-

[NLP] LLaDA: Large Language Diffusion Models 2025.06.29

-

[RLHF] DeepSeek의 GRPO(Group Relative Policy Optimization) 2025.01.23

소중한 공감 감사합니다