[NLP] Information-Transport-based Policy for Simultaneous Translation

Information-Transport-based Policy for Simultaneous Translation

link : https://aclanthology.org/2022.emnlp-main.65.pdf

Abstract

Simultaneous translation (ST)의 주요 챌린지는, 각 target token은 현재까지 받은 source token에만 기반하여 번역되고 지금까지 받은 소스의 information은 직접적으로 번역 퀄리티에 영향을 끼친다는 것이다. 그래서 얼마나 많은 소스의 정보를 받았는지는 ST policy가 번역할지 소스를 더 기다릴지 결정하는데 있어 pivotal evidence가 된다. 해당 논문에서는 'translation'을 'information transport'로 다루고, 'Information-Transport-based-Simultaneous Translation(ITST)'라는 방법론을 제안한다. ITST는 각 소스타겟부터 타겟 토큰까지에서 오는 transported information weight를 수치화하고, 그런 뒤 지금까지 받은 누적 information으로부터 타겟 토큰을 번역할지 말지 결정한다.

Introduction

full-sentence machine translation(MT)와 다르게 ST는 다음 소스 인풋을 기다릴지 혹은 타겟 토큰을 생성할지 결정하는 추가적인 read/write policy를 필요로 한다. ST에서 타겟 토큰을 생성하기 위해 partial 소스 인풋만을 받도록 restriction할 때, read write policy는 번역 퀄리티가 떨어지는 것을 완화할 수 있어야 한다. 이를 위해서 policy는 받은 소스 정보의 양이 충분한지 measure해서, 소스 인풋에 대한 정보가 타겟 토큰을 생성하기 충분한지 ensure할 수 있어야 한다.

이전의 read/write policy는 미리 정의된 룰을 따르는 Fixed policy가 있고 동적으로 read/write를 조정하는 adaptive policy가 있다. 이전 adaptive policy에 대한 연구는 종종 직접적으로 read/write decision을 나타내기 위해 input에 의존하는 variable을, explicitly 소스 정보에 대한 양을 모델링하지 않고, 예측하게 된다. 그래서 해당 논문에서는 받은 소스 정보를 read/write를 위한 evidence로 보는 reasonable read/write policy 기법을 제안한다.

ST process에서, 소스토큰은 정보를 '제공'하고, 타겟 토큰을 정보를 '받는다' 그런뒤, 번역을 수행하므로, 번역 프로세스는 소스로부터 타겟으로 가는 'information transport' 문제로 다룰 수 있다. 만약 우리가 각 소스로부터 타겟으로 가는 정보의 양이 얼만큼인지 잘 aware할 수 있다면, 현재 타겟 토큰을 위해 받은 소스 토큰에 의해 제공되는 총 정보를 파악해 소스 정보가 번역에 충분한지 확인하는 것은 자연스럽다.

2008년도에 제안된 optimal transport problem에 대한 아이디어를 빌려와 해당 논문에서는 ST 문제를 해결하기 위한 'Information-Transport-based Simultaenous Translation(ITST)'를 제안한다. ITST는 명시적으로 각 소스로부터 현재 타겟 토큰까지의 transported information weight를 정량화한다. 그런다음 ITST는 수신된 소스 토큰이 현재 타겟 토큰에 대해 제공하는 정보의 양이 충분한 비율에 도달했다고 판단하면 번역을 시작한다. Figure 1은 70%의 소스 정보는 번역에 충분하다고 가정한 경우를 나타낸 것이며, ITST는 각 소스토큰에서 현재 타겟 토큰까지의 transport information weight를 정량화한다.(그림의 0.15, 0.28 .. 이 이에 해당하는 weight이다.) 그림에서보면 3번째 토큰까지 받았을 때 info weight는 0.45이므로 70%가 넘지 않기 때문에 READ하며, 4번째 토큰까지 받았을 때는 누적 weight가 70%를 넘는 0.78이므로 WRITE하는 것이다.

The Proposed Method

ITST는 명시적으로 현재 생성된 타겟 토큰을 projected한 소스의 정보를 명시적으로 measure하며, ST process를 하는 동안 ITST는 각 소스토큰에서 타겟토큰으로 전송되는 정보의 양인 information transport를 모델링한다. 그런다음, ITST는 지금까지 받은 누적 정보가 충분하다고 판단하면 번역을 시작한다.

Information Transport

Information Transport 해당 논문은 1949년에 제안된 Optimal Transport problem(OT)의 아이디어를 빌려온다. 이는 전송 비용(Transport cost)를 최소화하면서 확률 분포를 다른 분포로 변환하는 Transport Matrix를 찾는 것을 목표로 한다. 이를 차용해 ST 번역 프로세스를 소스에서 타겟으로의 Transport information으로 취급한다. information transport를 matrix T = (T_{ij})_{IXJ}로 표기하고 T의 각 요소 T_{ij}는 0에서 1사이의 값이며, x_j로부터 y_i로가는 transported information weight를 나타낸다. 그런 다음, 번역을 위해 각 target token이 수신한 총 정보가 1이라고 가정한다. \Sum_{j=1}^J(T_ij) = 1.

이 정의에 따라 ITST는 transported information weight T_ij를 아래 수식처럼 정량화한다. 여기서 s_i는 target hidden state이고 z_j는 source hidden state이다. 여기서 V^Q와 V^K는 learnable parameter이다.

Constraints on Information Transport OT문제와 비슷하게, 번역에서 정보 전송을 모델링하려면, 전송되는 가중치 transported weights를 제약(constrain)하기 위한 transport cost도 필요하다. 특히 ST를 위해서는 번역과 지연(latency) 측면에서 information transport T를 제약해야 하는데, 번역 제약은 information transport가 소스에서 타겟으로의 번역 프로세스를 정확하게 반영할 수 있도록 해야하고, latency 제약은 비정상적인 번역 지역을 피하기 위한 information transport를 regularize해야 한다.

Translation constraints 를 위해서는, information transport T는 어떤 소스 토큰이 현재 target token 변역에 더 많이 기여하는지 파악해야 한다. 즉 translation process를 반영해야 하는 것이다. 다행이도 번역모델에서 cross-attention \alpha_ij는 소스토큰 x_j 가 타겟 토큰 y_i에 제공하는 weight를 제어하는데 사용되므로, information transport를 cross-attenion으로 통합할 수 있다. T_ij에 \alpha_ij를 곱하고 normalize를 한뒤 최종 attention \beta_ij를 구한다.

그런다음, context vector는 o_i = \Sum_{j=1}^J \beta_ij(z_j W^V)로 계산한다. 이러한 방법을 통해 information transport T는 번역 프로세스에서 original cross entropy loss를 통해 cross attention과 함께 학습될 수 있다.

Latency constraint의 경우 모델이 일정량의 정보를 수신한 후, 번역을 시작해야 하므로 T가 번역 지연 시간에 영향을 미친다. 특히 현재 target token로부터 lagging이 큰 소스에서 너무 많은 정보를 받았다면 해당 소스 토큰을 기다리는 동안 지연시간이 길어진다. 반면 앞부분 소스 토큰이 너무 많은 정보를 제공하면 모델이 번역을 조기에 시작하게 되여 latency는 줄어들지만 번역의 품질이 저하된다. 따라서 현재 타겟 토큰의 위치에 비해 너무 일찍 또는 너무 늦게 위치한 소스 토큰에서 너무 많은 정보 가중치가 전송되는 것을 방지해서 적절한 지연시간을 확보하는 것을 목표로 한다. 이를 위해 diagonal form의 latency cost matrix C = (C_ij)_{IXJ}를 정의하고 information transport를 softly regularize한다. C_ij는 x_j부터 y_i로의 transporting information의 relative offset인 latency cost이다.

위에서 정의한 latency cost matrix C가 주어지면, information transport T와 C를 곱한 것이 latency loss L_latency가 된다.

Learning Objective 제안된 information transport T를 사용한 ST model theta의 학습은 아래와 같이 정의된다.

(8) 은 총 information transport를 1로 제약하고, (9)는 transported weight를 sigmoid를 통해 양수로 제약한다. 그리고 (8)의 T_ij의 normalization constraint를 주어 아래와 같이 변경한다.

그러므로 최종 loss L_ITST는 cross entropy, latency, noramlization loss를 모두 더한 값이 된다.

Information Transport based Policy

스트리밍 input을 통해 ITST는 소스 토큰을 하나씩 받아 현재 타겟 토큰으로 정보를 전송하고, 누적된 수신 정보가 충분할 때 번역을 시작한다. test time동안 번역을 위한 소스 정보가 얼마나 충분한지에 대한 비율을 나타내는 threshold를 통해 latency를 컨트롤 하게 된다.

evaluation 에서 학습된 알고리즘을 통해 read write policy를 사용하는 알고리즘은 위와 같다. 현재 타겟 토큰에서 받은 소스의 누적 정보량이 threshold 이상이면 Write하고 그렇지 않으면 Read한다.

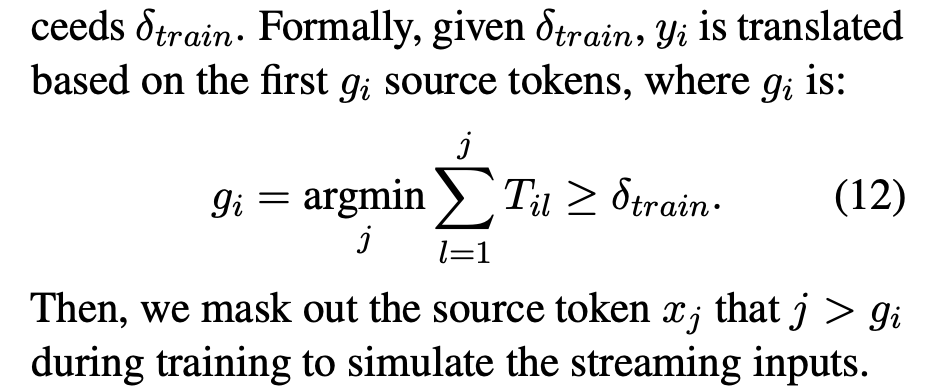

Curriculum-based Training ST model은 imcomplete source information에 기반한 번역도 가능해야 한다. 그러므로 누적된 각 타겟 토큰의 정보가 \delta_train을 초과하면 나머지 소스 토큰을 마스킹하여 \delta_train threshold를 학습에도 적용했다.

임의의 latency에서도 ST를 잘 수행할 수 있도록 하기 위해 threshold를 여러개로 나누거나 랜덤하게 다른 threshold를 샘플하는 이전 접근법들과는 달리 해당 논문에서는 curriculum-based training을 제안한다. 이는 easy-to-hard schedule을 따르는 방법인데, 학습 초기에는 model이 translation과 information transport가 풍부한 소스 정보에서 학습될 수 있도록 한다. 그런다음, 점진적으로 소스 정보량을 줄여 incomplete 소스에 대해서 번역을 학습하도록 한다. 그러므로 \delta_train은 dynamicaaly 아래 exponential-decaying schedule을 따르도록 조정된다.

'자연어 NLP' 카테고리의 다른 글

당신이 좋아할만한 콘텐츠

-

[RLHF] DPO: Direct Preference Optimization, DPO 2023.12.03

-

[NLP] OpenKorPOS: Democratizing Korean Tokenization withVoting-Based Open Corpus Annotation 2023.07.14

-

[NLP] Translation-based Supervision for Policy Generation in Simultaneous Neural Machine Translation 2023.05.12

-

[RLHF] PEBBLE: Feedback-Efficient Interactive Reinforcement Learning via Relabeling Experience and Unsupervised Pre-training 2023.04.30

소중한 공감 감사합니다